NVIDIA H200 Tensor Core

پردازنده گرافیکی NVIDIA H200 جدیدترین عضو خانواده کارتهای شتابدهنده محاسباتی انویدیا مبتنی بر معماری Hopper است که در نوامبر ۲۰۲۳ معرفی شد. این پردازنده با تمرکز بر افزایش کارایی در مدلهای بزرگ زبانی (LLM) و محاسبات علمی، بهبودهای چشمگیری در پهنای باند حافظه و ظرفیت آن ارائه میدهد.

- مشخصات کلی معماری

| پارامتر |

مقدار |

| معماری |

Hopper نسل بعدی (H100) |

| فرآیند ساخت |

TSMC 4N (4nm) بهینه شده |

| ترانزیستورها |

~80 میلیارد |

| تنسور کورها |

پشتیبانی از FP8، FP16، TF32، FP64 |

| NVLink |

900GB/s پهنای باند |

| PCIe |

نسخه 5.0 |

- بهبودهای کلیدی نسبت به H100

(الف) ارتقاء سیستم حافظه

- حافظه HBM3 با پهنای باند 4.8TB/s (50% سریعتر از H100)

- ظرفیت حافظه 141GB (افزایش 76% نسبت به H100 با 80GB)

- تاخیر کمتر در دسترسی به حافظه

(ب) بهینهسازی برای مدلهای بزرگ زبانی (LLM)

- 2x افزایش عملکرد در استنتاج مدلهایی مانند GPT-4 و LLaMA

- پشتیبانی بهبودیافته از محاسبات 8 بیتی (FP8)

(ج) مصرف انرژی کارآمدتر

- بهبود عملکرد به ازای هر وات نسبت به H100

- فناوری خنککاری پیشرفته برای چگالی محاسباتی بالاتر

- عملکرد محاسباتی

| دقت محاسباتی |

عملکرد (هر GPU) |

| (FP64) محاسبات علمی |

~60 TFLOPS |

| (TF32)هوش مصنوعی |

~1,100 TFLOPS |

| FP16/BF16 |

~2,300 TFLOPS |

| FP8 |

~4,600 TFLOPS |

- مشخصات حافظه

| ویژگی |

مقدار |

| نوع حافظه |

HBM3 |

| ظرفیت |

141GB |

| پهنای باند |

4.8TB/s |

| حافظه نهان L2 |

50MB |

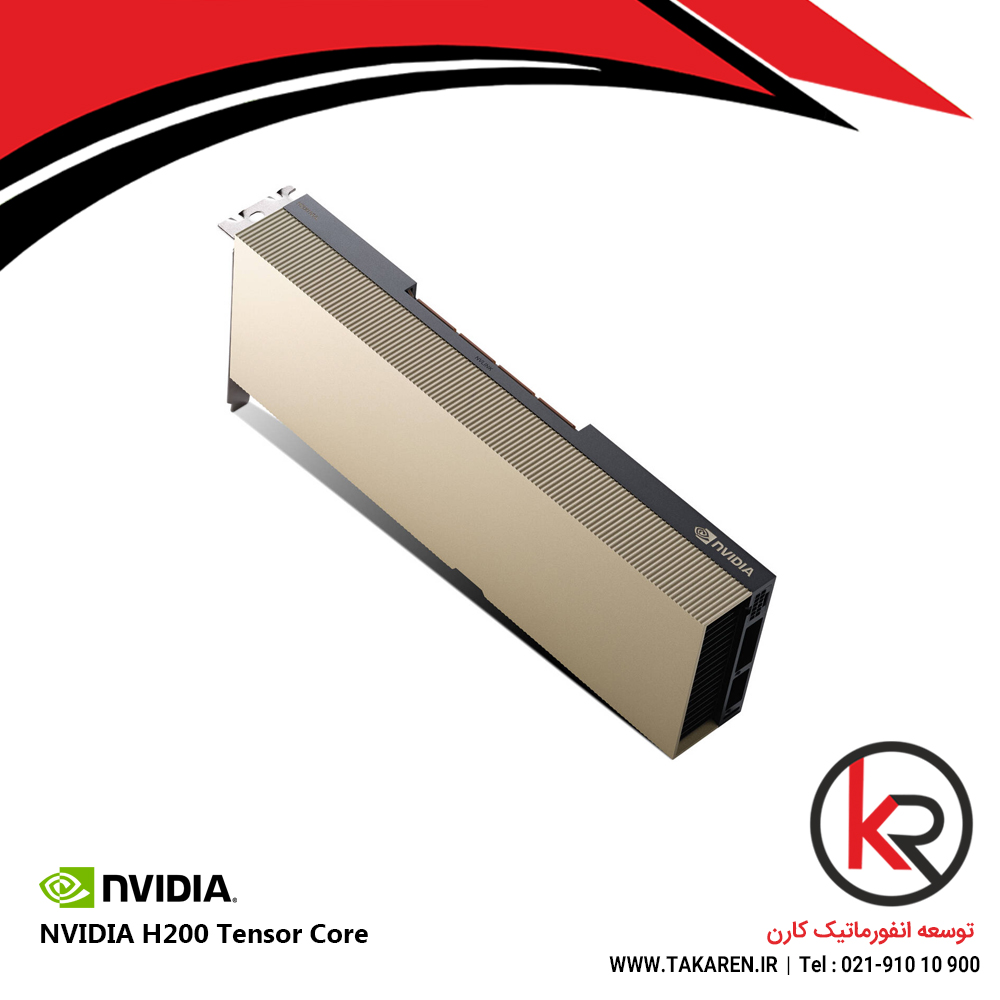

- پیکربندیهای مختلف

| مدل |

توان مصرفی (TDP) |

رابط اتصال |

| H200 SXM |

700W |

NVLink 4.0 |

| H200 PCIe |

350W |

PCIe 5.0 |

| H200 NVL پیکربندی دوگانه |

~1000W |

NVLink Bridge |

- مقایسه با نسل قبلی (H200 vs H100)

| معیار |

H200 |

H100 |

بهبود |

| ظرفیت حافظه |

141GB |

80GB |

+76% |

| پهنای باند حافظه |

4.8TB/s |

3TB/s |

+60% |

| عملکرد FP8 |

4.6 PetaFLOPS |

4 PetaFLOPS |

+15% |

| عملکرد استنتاج LLM |

2x سریعتر |

Baseline |

100% |

- کاربردهای اصلی

- مدلهای بزرگ زبانی (LLM)

- آموزش و استنتاج مدلهایی با صدها میلیارد پارامتر

- محاسبات علمی (HPC)

- شبیهسازیهای آب و هوایی، دینامیک سیالات محاسباتی (CFD)

- پردازش دادههای کلان

- تحلیل دادههای عظیم در مراکز داده

- هوش مصنوعی صنعتی

- مدلهای تشخیص تصویر و پردازش زبان طبیعی (NLP)

نتیجهگیری

پردازنده NVIDIA H200 با تمرکز بر افزایش ظرفیت و پهنای باند حافظه، گامی بلند در تسریع کاربردهای هوش مصنوعی و محاسبات محسوب میشود. بهبود 60% در پهنای باند حافظه و ظرفیت GB141 آن را به انتخابی ایدهآل برای مدلهای بزرگ زبانی تبدیل کرده است. این پردازنده در سال 2024 در دسترس خواهد بود و انتظار میرود استاندارد جدیدی در صنعت شتابدهندههای AI/HPC تعیین کند.

دیدگاهها

پاککردن فیلترهاهیچ دیدگاهی برای این محصول نوشته نشده است.