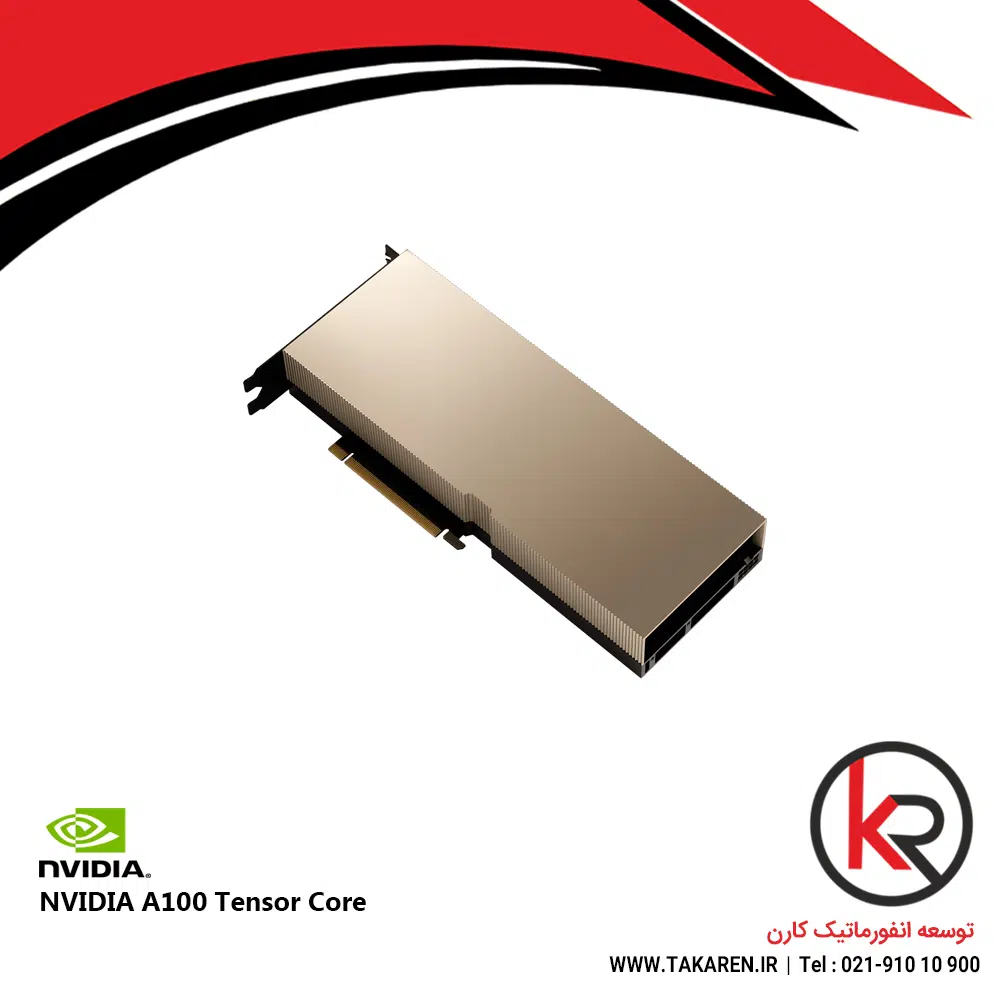

کارت گرافیک A100 Tensor Core

A100 Tensor Core

مشخصات فنی:

FP64 Tensor Core: 19.5 ترافلاپس

Tensor Float 32 (TF32): 156 ترافلاپس (312 ترافلاپس با تنکسازی)

FP16 Tensor Core: 312 ترافلاپس (624 ترافلاپس با تنکسازی)

INT8 Tensor Core: 624 ترااپس (1,248 ترااپس با تنکسازی)

حافظه GPU: 40 گیگابایت HBM2 یا 80 گیگابایت HBM2e

پهنای باند: تا 2,039 گیگابایت بر ثانیه

توان طراحی حرارتی: 250 وات (PCIe) تا 400 وات (SXM)

فرمفاکتورها: PCIe و SXM4

NVLink: تا 600 گیگابایت بر ثانیه

PCIe Gen4: 64 گیگابایت بر ثانیه

پشتیبانی از سیستمهای NVIDIA HGX A100 با تا 16 GPU.

دسته: کارت گرافیک

برچسب: a100, nvidia, خرید gpu, کارت گرافیک

دیدگاهها

پاککردن فیلترهاهیچ دیدگاهی برای این محصول نوشته نشده است.